作者 vmunix

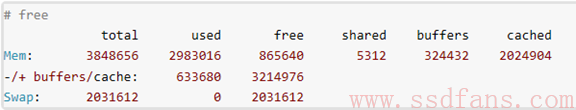

据说很少有人能说清楚 free 命令所显示的 “buffers” 与 “cached” 之间的区别:

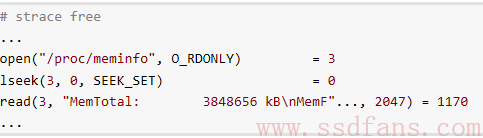

那我们来挑战一下如何?就从分析 free 命令开始吧。先用 strace 跟踪一下,看能不能发现 free 命令是如何计算 “buffers” 和 “cached” 的:

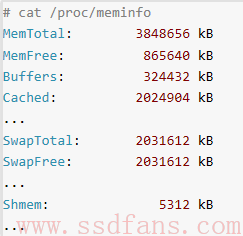

很显然,free 命令是从 /proc/meminfo 中读取信息的,跟我们直接读到的结果一样:

那么 /proc/meminfo 中的 “Buffers” 和 “Cached” 又是如何得来的呢?这回没法偷懒,只能去看源代码了。源代码文件是:fs/proc/meminfo.c ,我们感兴趣的函数是:meminfo_proc_show(),阅读得知:

- “Buffers” 来自于 nr_blockdev_pages() 的返回值。

- “Cached” 来自于以下公式:

global_page_state(NR_FILE_PAGES) – total_swapcache_pages – i.bufferram

先看”cached”:

以上计算cached的公式中,global_page_state(NR_FILE_PAGES) 来自 vmstat[NR_FILE_PAGES],表示所有的缓存页(page cache)的总和,它包括:

- Cached

- buffers

- 交换区缓存(swap cache)

这里简单解释一下swap cache:

那些匿名内存页,比如用户进程通过malloc()申请的内存页是没有关联任何文件的(有别于backing storage基于磁盘文件的内存页),如果发生swapping换页,这类内存页会被写入交换区。从一个匿名内存页被确定要被换页开始,它就被计入了swap cache,但是不一定会被立刻写入物理交换区,因为Linux的原则是除非绝对必要,尽量避免I/O。所以swap cache中包含的是被确定要swapping换页、但是尚未写入物理交换区的匿名内存页。

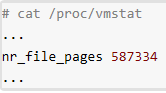

vmstat[NR_FILE_PAGES] 可以通过 /proc/vmstat 来查看,表示所有缓存页的总数量:

注意以上nr_file_pages是以page为单位,而不像free命令是以KB为单位,一个page等于4KB。

直接修改 nr_file_pages 的内核函数是:

__inc_zone_page_state(page, NR_FILE_PAGES) 和

__dec_zone_page_state(page, NR_FILE_PAGES),

一个用于增加,一个用于减少。

“Cached” 就是除去 “buffers” 和 “swap cache” 之外的缓存页的数量。所以关键还是要理解 “buffers” 是什么含义。

来看看”buffers” :

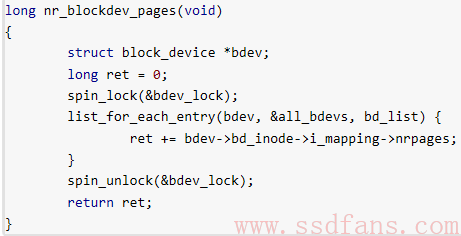

从源代码中看到,”buffers” 来自于 nr_blockdev_pages() 的返回值,我们来看一下这个函数是干什么的:

这段代码很简单,意思是遍历所有的块设备(block device),累加每个块设备的inode的i_mapping的页数,统计得到的就是 buffers。所以很明显,buffers 是与块设备直接相关的。

那么谁会更新块设备的缓存页数量(nrpages)呢?我们继续向下看。

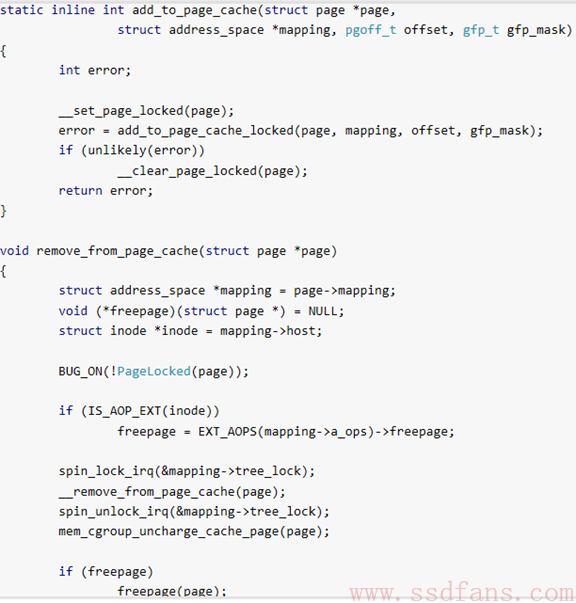

搜索kernel源代码发现,最终更新mapping->nrpages字段的函数就是add_to_page_cache和__remove_from_page_cache:

这两个函数是通用的,block device 和 文件inode 都可以调用,至于更新的是块设备的(buffers)还是文件的(cached),取决于调用参数变量mapping:如果mapping对应的是文件inode,自然就不会影响到 “buffers”;如果mapping对应的是块设备,那么相应的统计信息会反映在 “buffers” 中。我们下面看看kernel中哪些地方会把块设备的mapping传递进来。

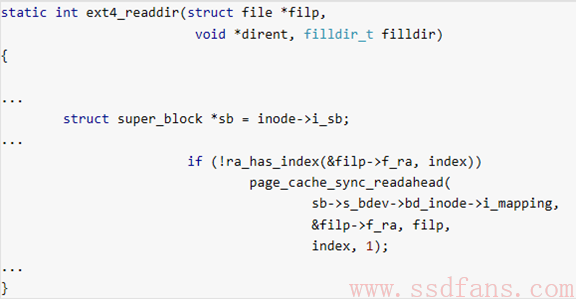

搜索内核源代码发现,ext4_readdir 函数调用 page_cache_sync_readahead 时传递的参数是 sb->s_bdev->bd_inode->i_mapping,其中s_bdev就是块设备,也就是说在读目录(ext4_readdir)的时候可能会增加 “buffers” 的值:

继续琢磨上面的代码,sb表示SuperBlock,属于文件系统的metadata(元数据),突然间一切恍然大悟:因为metadata不属于文件,没有对应的inode,所以,对metadata操作所涉及的缓存页都只能利用块设备mapping,算入 buffers 的统计值内。

打个岔:ext4_readdir() 中调用 page_cache_sync_readahead() 显然是在进行预读(read-ahead),为什么read-ahead没有使用普通文件inode的mapping,而是使用了底层的块设备呢?从记载在补丁中的说明来看,这是一个权宜之计,看这里,所以不必深究了。

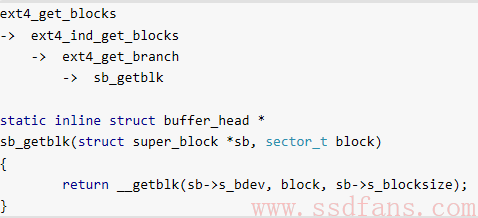

举一反三,如果文件含有间接块(indirect blocks),因为间接块属于metadata,所以走的也是块设备的mapping。查看源代码,果然如此:

这样,我们就知道了,”buffers” 是块设备(block device)占用的缓存页,分为两种情况:

- 直接对块设备进行读写操作;

- 文件系统的metadata(元数据),比如 SuperBlock。

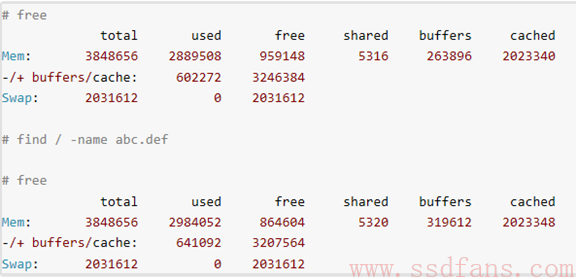

现在我们来做个测试,验证一下上述结论。既然读取EXT4文件系统的目录会使用到 “buffers”,我们用 find 命令扫描文件系统,观察 “buffers” 增加的情况:

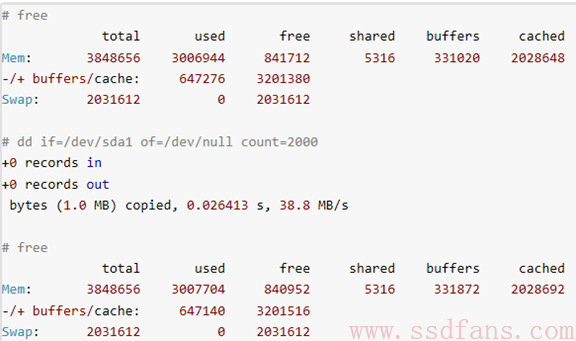

再测试一下直接读取block device,观察”buffers”增加的现象:

结论:

free 命令所显示的 “buffers” 表示块设备(block device)所占用的缓存页,包括直接读写块设备、以及文件系统元数据(metadata)如SuperBlock所使用的缓存页;

而 “cached” 表示普通文件所占用的缓存页。

作者vmunix大侠博客是http://www.linuxperf.com,新浪微博http://weibo.com/vmunix