作者 唐杰

JBOF的思考

和上篇的讨论一样,PCIE接口的JBOF的确不受待见。Kalary【6】,这个做众核的网络处理器的公司,也在讨论40G/80G的JBOF方案(因为是ASIC,25G/100G没ready,但是产品应该在路上)。Newisys 【7】和Kazan合作的JBOF也是最近几年的明星。Kazan使用FPGA方案做NVMeoF方案,已经顺利拿到投资了。

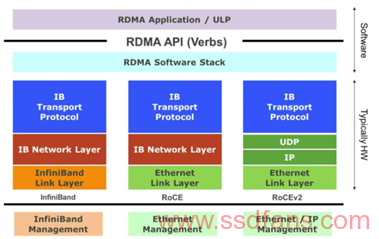

JBOF使用PCIE 接口的确成本和代价过高。100G应该是大家公认的接口了。100G RDMA的当红厂家Mellanox【8】也是当仁不让提出了后Biuefeild的方案。在目前Bluefeild的方案中,数据流程必[……]